크롤러: robots.txt 파일에 연결할 수 없음 해결 방법, 후기

안녕하세요. 준준 아빠입니다. 오늘 티스토리 이야기에서는 "크롤러: robots.txt 파일에 연결할 수 없음" 해결 방법과 해결 후기에 대해서 다루어 보도록 하겠습니다. 지난 포스팅에서 말씀드렸듯이 "내가 겪은 것이라면 다른 누구도 겪을 수 있는 일이고 나에게 도움이 되었다면 다른 누구에게도 도움이 되겠다" 싶어 포스팅하게 되었습니다.

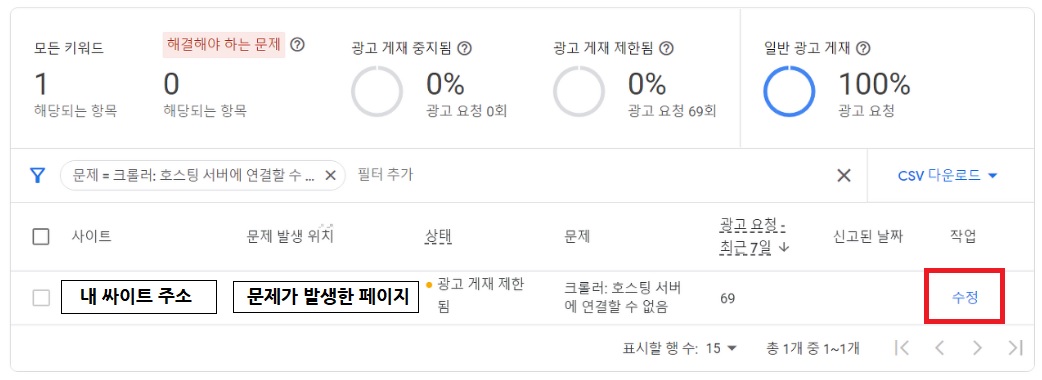

다음 저품질이 풀리고 기쁨도 잠시 에드센스에 접속해 보니, 상단에 '광고 크롤러 오류가 있으며 , 이 때문에 수익 손실이 발생할 수 있습니다."라는 문구를 보게 되었습니다. 수익이 얼마나 된다고 여기서 수익 손실이 발생하면 어쩐담 놀랜 마음을 다잡고 에드센스 정책센터에 들어가 보았습니다. 아래와 같이 '문제가 발생한 페이지 주소', '상태: 광고 게재 제한됨', '문제: 크롤러 호스팅 서버에 접속할 수 없음', '신고된 날짜', '맨 마지막이 수정을 볼 수 있습니다. 수정을 눌렀습니다. 다음 페이지에서 '크롤러: robots.txt 파일에 연결할 수 없음'이라는 문구가 있는 것을 보게 되었습니다.

티스토리 전체가 그런 것은 아니었고, 포스팅 1개에서 이런 현상이 발생하였습니다. 경우의 수가 너무 많기 때문에 꼭 이 방법이 맞다고 할 수는 없지만, 저는 이렇게 해서 바로 해결할 수 있었습니다.

문제의 원인은 뭐고 해결책은 무엇일까요?

크롤러: robots.txt 파일에 연결할 수 없음 어떻게 해결할 수 있을까?

1. robots.txt이란?

참 생소하기도 한 'robots.txt'. 이게 뭐지 하며 검색을 해 보았습니다. 구글에서는 이렇게 소개해 놓았습니다.

"robots.txt 파일은 크롤러가 사이트에서 액세스 할 수 있는 URL을 검색엔진 크롤러에 알려 줍니다."

크롤러는 "웹을 돌아다니며 유용한 정보를 찾아 특정 데이터베이스로 수집해 오는 프로그램"이고, 로봇들이 웹사이트들의 내용을 수집하는 과정을 '크롤링'이라고 부릅니다. 액세스는 "인터넷상의 특정 문서, 주소, 사이트로 이동하거나 특정 파일을 불러올 경우 그곳으로 이동하여 접근하는 과정"입니다.

따라서 robots.txt의 기능은 다음과 같이 이해할 수 있겠습니다. 'robots.txt'이란 검색 로봇들이 내 웹사이트 혹은 티스토리 및 블로그에 접근 할 때 접근할 수 있는 권한을 주는 파일입니다. 'robots.txt'의 조작을 통해 특정 검색로봇은 오지 못하도록 할 수 있습니다. 또한 특정 폴더는 검색할 수 없도록 제한할 수 있습니다.

그러므로 "크롤러: robots.txt 파일에 연결할 수 없음"은 '어떠한 상황'으로 인해 에드센스 크롤러가 내 페이지에 접근할 수 없는 상황을 말하는 것입니다.

2. robots.txt 볼 수 있는 방법. (robots.txt 확인 방법)

robots.txt가 내 사이트에서 잘 작동되고 있는지를 보려면 내 주소 뒤에 /robots.txt를 해 주면 됩니다.

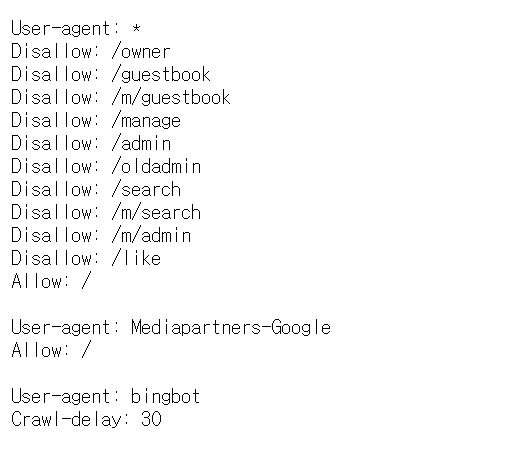

가령 저의 경우는 "https://goodnews7942.tistory.com/robots.txt"입니다. 이렇게 자신의 주소에 /robots.txt를 넣으면 아래와 같은 화면을 볼 수 있습니다.

해석은 다음과 같습니다.

User-agent: * 검색 로봇은 내 사이트에 들어와도 된다.

하지만 Disallow 된 폴더들은 검색 불허한다.

User-agent : Mediapartners-Google

Allow: /

Google 로봇은 모든 것을 허용한다.

User-agent : bingbot

Crawl-delay: 30

bingbot 로봇은 크롤링을 30초마다 한 번씩만 허용한다.

티스토리 블로그의 경우 robots.txt는 별도 만질 필요가 없습니다. 왜냐하면 블로그를 만들면 robots.txt가 자동 생성되기 때문입니다.

제 티스토리 블로그는 'robots.txt'가 잘 작동되고 있었습니다. 그런데 왜 한 개의 포스팅에서 "크롤러:robots.txt 파일에 연결할 수 없음"문제가 발생한 것일까요? 트랙픽이나, 사이트 내 문제로 인하여 애드센스 크롤러가 해당 포스팅에 접근할 수 없게 된 것입니다. 따라서 문제 해결은 이렇게 하면 됩니다. "크롤러: robots.txt 파일에 연결할 수 없음"의 경우, 문제를 일으키는 '해당 페이지'에 '에드센스 크롤러'가 접근할 수 있도록 도와주면 됩니다.

방법은 아래와 같습니다.

3. "크롤러: robots.txt 파일에 연결할 수 없음" 해결 방법

구글 에드센스에 들어갑니다. 좌측 상단에 세줄 로고를 누르시고 메뉴로 들어갑니다. → 메뉴 하단에 계정을 누릅니다. → '액세스 및 승인'을 누릅니다. → 그리고 '크롤러 액세스'를 누릅니다.

'크롤러 액세스'에 들어오게 되면 아래와 같은 화면이 보입니다. 그러면 우측 "로그인 추가"를 클릭해 줍니다.

이제 거의 다 왔습니다. 아래와 같은 화면이 보이실 텐데요. 아래 같이 순서대로 진행해 주시면 됩니다.

- 제한된 디렉터리 또는 URL: 오류가 발생한 내 페이지 주소

- 로그인 URL : 티스토리 블로그 주소

- 로그인 방식: 'POST'

- 사용자 이름: 카카오 계정 아이디 (양쪽 같게)

- 비밀번호: 카카오 계정 비밀번호 (양쪽 같게)

robots.txt의 문제를 일으키는 포스팅에 에드센스 크롤러를 직접 접근시켜 문제를 해결하는 방식인 것 같았습니다.

처음에는 확인 중이라고 하면서 적색이 켜지게 됩니다. 그런데 시간이 지나면 아래와 같이 녹색 버튼이 들어오는 것을 볼 수 있습니다. 이와 더불어, 에드센스 메인 상단에 '문제의 메시지'도 없어지게 됩니다. 저의 경우 해결까지 약 1~2시간이 걸렸던 것 같습니다.

오늘은 "크롤러: robots.txt 파일에 연결할 수 없음"에 대한 해결 방법에 대해서 알아보았습니다. 이 밖의 다양한 원인으로 문제가 발생되기 때문에 꼭 위에 제시된 방법으로 해결된다는 보장은 없습니다. 그러나 저의 경우는 위와 같은 방법으로 해결할 수 있었기에 그 방법을 공유합니다.

문제가 잘 해결되시길 바라겠습니다. 이제까지 준준 아빠였습니다. 모두 행복하세요.

'문화 > 티스토리 이야기' 카테고리의 다른 글

| 티스토리 4개월차, 네이버, 구글 유입자 수, 애드센스 100달러 (0) | 2023.05.03 |

|---|---|

| 티스토리 3개월 차 다음, 네이버, 구글 유입자 수 (0) | 2023.04.01 |

| 애드센스 핀번호 입력 1달러가 100달러 되기까지 (0) | 2023.03.09 |

| 블로그 저품질 확인, 증상, 원인, 해결 방법, 탈출 후기 (0) | 2023.02.14 |

| 에드센스 승인을 위해 꼭 필요한 5가지 (에드센스 승인 방법, 에드센스 합격 후기) (1) | 2023.01.28 |

댓글